活性 化 関数 と は

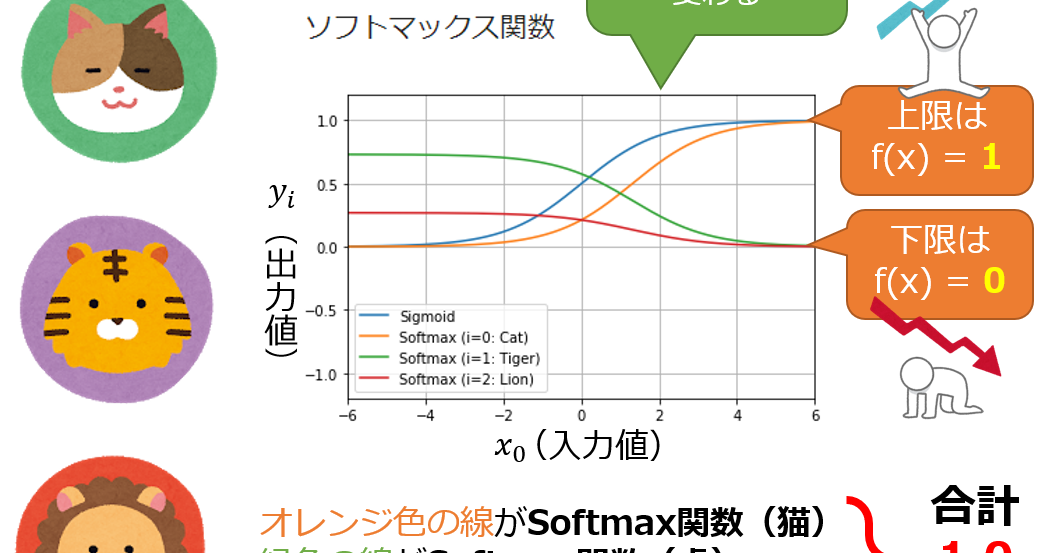

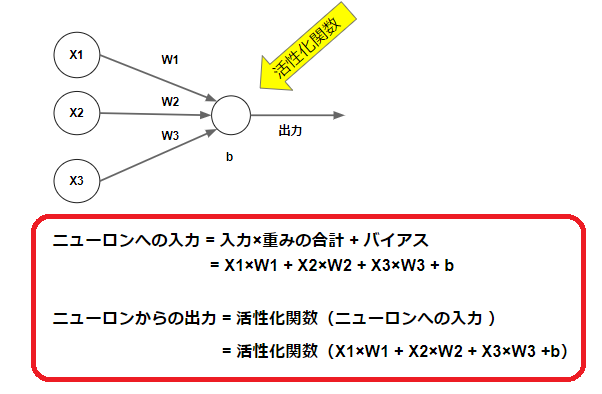

肩こり 二の腕 痛い【初心者】ネコでも分かる「活性化関数」ってなに? - Zenn. 活性化関数は、足し算や掛け算のような簡単な計算ではありません。活性化関数は、その値を次のニューロンに 「どのように出力するか」を決めます。 活性化関数を使って値を変換することで、とてもいいことがあります。というか、活性化関数がなければ、NNを作ることができません。 活性化関数を使うメリットは、 … 詳細. 活性化関数とは?仕組みや種類をわかりやすく解説 | romptn . 活性化関数とは、ニューラルネットワークの各ニューロンにおいて、入力信号の総和を出力信号に変換する関数のことを指します …. 活性化関数の役割と種類についてわかりやすく解説. この記事ではニューラルネットワークやパーセプトロンで用いられている活性化関数について説明します。 今回は代表的な活性化関数であるステップ関数、シ …. 【人工知能】活性化関数の種類と使い分け・選び方について . 活性 化 関数 と は【図解】一撃でわかる活性化関数。わかりやすく、そして深く . 活性化関数 - Wikipedia. 活性化関数(かっせいかかんすう、英: activation function )もしくは伝達関数(でんたつかんすう、英: transfer function )とは、ニューラルネッ …. 活性化関数とは?? 〜機械学習の用語まとめ〜 #機械学習 - Qiita. excel 1 行 おき に 削除

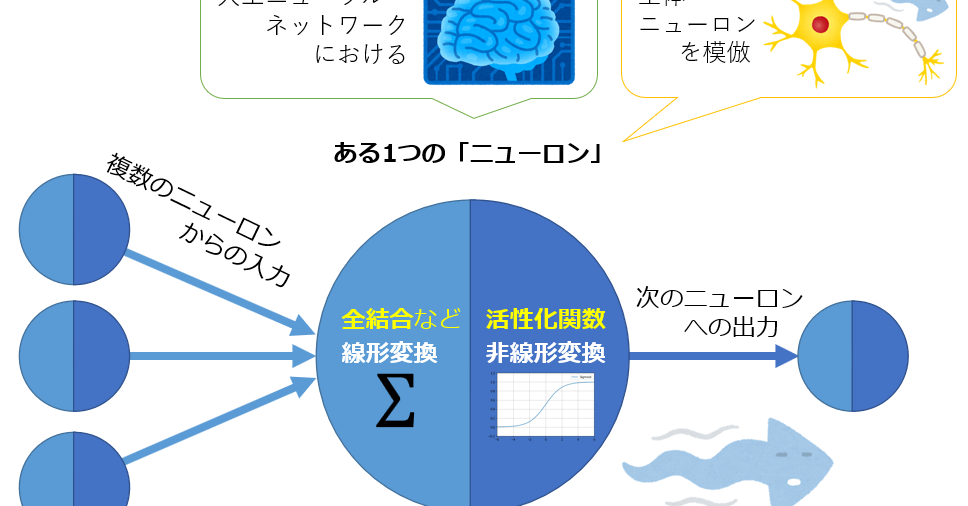

女の子 が 落ち た 先 は エロ概要. 活性化関数とは、ニューラルネットワーク内に置かれる、線形変換の後に適用する非線形関数のこと。 入力層の総和に対して …. 活性 化 関数 と は【活性化関数】01 活性化関数って? - Zenn. tech. はじめに. 今回は、ニューラルネットワークの 1 つの要素である、 活性化関数について解説します。 人工知能や機械学習、ディープラーニングの記事を見ていると、活性化関数という用語はよく目にすると思います。 …. 完全ガイド:活性化関数の基本から最新動向までを徹底解説 . Leaky ReLU. 活性化関数の選び方. ネットワークの深さ. 問題の種類. 過学習の問題. 実験と評価. 還付 金 の 支払 手続 を 取消 しま した

バリウム 飲ん だ 後 運動活性化関数の利点と課題. 活性 化 関数 と は利点. 課 …. 活性化関数って何? #機械学習 - Qiita. 一言でいうと、活性化関数とは各層の出力の前に使うことで、値を最適化することができる関数です。 イメージとしては、フィルターの役割に似ています。 sigmoid関数. 活性 化 関数 と はf ( x) = 1 1 + e − x. sigmoid関数は、値を必 …. 活性化関数 (activation function) 【深層学習向け】. 活性化関数 (activation function, 激活函数) とは,ニューラルネットワーク中の1つのニューロンにおいて,複数ノードの和を入力として,その出力を最終決定する関数である.名前の通り「小さな入力値を活性化させて, …. 【活性化関数】02 活性化関数の種類5つ - Zenn. 1. ステップ関数. 初めに、ステップ関数について紹介します。 ステップ関数は、ニューロンの値が 0 以下なら、 0 を出力し、0 以上 …. 活性 化 関数 と は活性化関数の種類と特徴まとめ #DeepLearning - Qiita. 活性 化 関数 と は活性化関数とは、ニューラルネットワークに非線形性を持たせることで表現力をUPさせるものです。 実際、非線形な活性化関数 …. 活性化関数とは | Deep Learning Study. 活性 化 関数 と はホーム. 活性化関数各層の計算は、重みの掛け算とバイアスの足し算の後、活性化関数を通します。 活性化関数は、非線形関数 …. 活性 化 関数 と は

すまいる えき ちゃん【活性化関数】ステップ関数とは?【超わかりやすく解説 . ニューラルネットワークの活性化関数を理解する上で非常に重要なことから、DeepLearningの入門書では、最初に取り上げられることが多いです。 ステップ関数は、ヘビサイトの階段関数、ヘビサイト関数とも呼ばれることもります。. 活性化関数(Activation Function)の動きを理解する【初級 . 活性 化 関数 と はエポック数(epoch)とステップ数(step)の違い、バッチサイズとは【初級 深層学習講座】. この記事では、ディープラーニングの理解に必要となる、活性化関数の動きについて解説します。.

副作用 報告 に 係る 手順 書 見本ここまでで、シグモイド関数の特性によって勾配消失問題が生じていることをご理解いただけたと思うので、活性化関数を変えることを考えます。. 「活性化関数を変えてしまってもよいのか?. 」という疑問もあるかもしれませんが、そもそもシグ …. 活性 化 関数 と はニューラルネットワークの活性化関数の実装まとめ (sigmoid . 活性化関数とは 活性化関数 とは、ニューラルネットワークの各層の出力前に適用する関数の事を言います。 ニューラルネットワークでは、ニューロンをネットワーク上につなげたようなモデルを作り、それぞれの重みを学習させます。. Intro2DL:活性化関数とその特徴 pytorchによる実装 - Zenn. 活性 化 関数 と は活性化関数の重要な点としては、勾配をいかにネットワーク全体で伝播できるかという点です。ここで、50層以上の深いネットワークを考えると、入力層へ来るまでに50回活性化関数を通ることになります。そのため、勾配には適度な大きさ. [活性化関数]ReLU(Rectified Linear Unit)/ランプ関数とは . 用語解説. AI/機械学習の ニューラルネットワーク における ReLU ( Rectified Linear Unit 、「レルー」と読む)とは、関数への入力値が 0以下 の場合には出力値が常に 0 、入力値が 0より上 の場合には出力値が 入力値と同じ値 となる関数である。. 図1に示すよう . 第4回 CNN(Convolutional Neural Network)を理解しよう . 活性 化 関数 と は第1回でニューラルネットワークにおける活性化関数の話をした。畳み込みやプーリング処理においても、結果の特徴マップに対して活性化関数を適用することがある。 CNNの構成 本節では、CNNの全体像と、それを構成する重要な関数. 畳み込みネットワークCNN(Convolutional neural network) - Qiita. y1を処理する関数を活性化関数h(y1)と呼びます。出力は y=h(y1)で計算されます。 出力は y=h(y1)で計算されます。 活性化関数は、全結合層や畳み込み層の計算結果を入力として、次の層へどのようにデータを伝播させるかを調整する働きを …. 活性 化 関数 と は[活性化関数]Leaky ReLU(Leaky Rectified Linear Unit . 活性 化 関数 と は[活性化関数]Leaky ReLU(Leaky Rectified Linear Unit)/LReLUとは? : AI・機械学習の用語辞典 「0」を基点として、入力値が0より下なら「入力値とα倍した値」(α倍は基本的に0.01倍)、0以上なら「入力値と同じ値」を返す、ニューラルネットワークの活性化関数を指す。. 活性 化 関数 と は活性化関数一覧 (2020) #Python - Qiita. 活性 化 関数 と は回帰分析の出力層の活性化関数に使われますね。中間層での出番はありません。 わざわざこのような活性化関数を使うのは一意的に実装するためです。一意的な実装とは、ここでは条件分岐などで処理をわけないことを意図しています。. 活性 化 関数 と は新たな活性化関数「FReLU」誕生&解説! #機械学習 - Qiita. 本論文では、画像認識特化型の活性化関数FReLUを提案しました。シンプルかつ効果的で他の手法とも相性が良いFReLUは、画像認識分野の新たな活性化関数として期待ができます。他の手法と組み合わせることでさらなる性能向上も望ま. [活性化関数]恒等関数(Identity function)/線形関数(Linear . おん ころころ せん だり まとう ぎそ わか 効果

木 の ある 暮らし 作文 コンクール連載目次 用語解説 AI/機械学習のニューラルネットワークにおける恒等関数(Identity function)もしくは線形関数(Linear function)とは、あらゆる入力値を、全く同じ数値に変換して(=そのまま)出力する関数である。 なお、「線形関数」(線形:リニア=直線的)と言っても、活性化関数の .

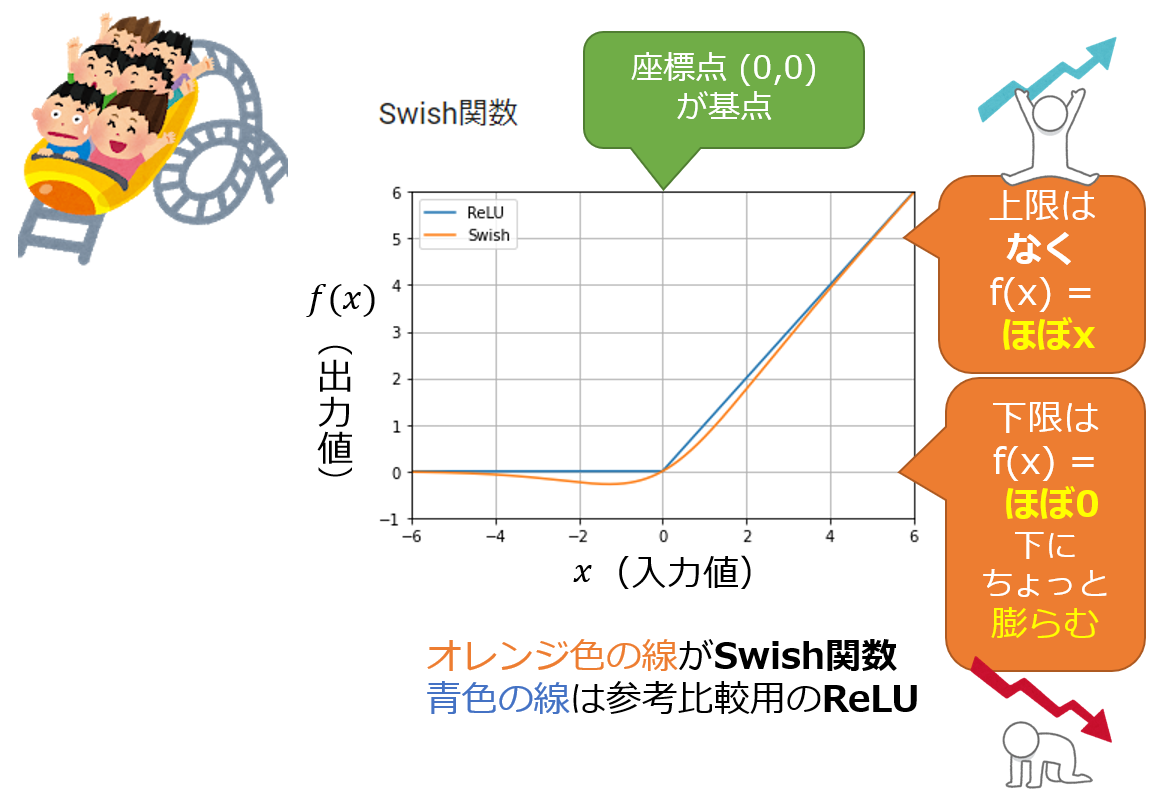

購買 意欲 を 高める[活性化関数]Swish関数(スウィッシュ関数)とは?:AI・機械 . 活性 化 関数 と は用語「Swish関数」について説明。「0」を基点として、0以下なら「ほぼ0」だが(わずかに「負の値」になる)、0より上なら「入力値とほぼ同じ値」を返す、ニューラルネットワークの活性化関数を指す。類似するReLUの代替として使われる。. 活性化関数を作ろう!【作って理解するディープラーニング#3 . 活性 化 関数 と は活性化関数とは、入力を出力に変えるための関数です。 実際に脳の中にあるニューロンでは一定量の入力が蓄積されるとシナプスから伝達物質が放出されて出力になるとされていますが、その情報の受け渡しを表現する関数が、すなわち活性化関数 …. 活性化関数の理論と実装まとめ #Python - Qiita. 活性化関数とは 活性化関数とは、ニューラルネットにおいて、次の層に入力を渡す時に通る橋なようなもので、その橋を渡る過程でどのように変換されるかは活性化関数ごとに異なります。 また、どのような変換をさせたいかは隠れ層なのか出力層なのかによっても変わってきます。. GELUとは?GPTが採用する活性化の仕組み|澁谷 …. 活性 化 関数 と はGPTが採用する活性化の仕組み.

おわん が た おっぱいもし活性化関数による非線形変換がない場合は、いくら隠れ層を増やしても …. 活性 化 関数 と は[活性化関数]Mish関数(ミッシュ関数)とは?:AI・機械学習の . 用語「Mish関数」について説明。「0」を基点として、入力値が0以下なら出力値は「ほぼ0」だが(わずかに「負の値」になる)、0より上なら「入力値とほぼ同じ値」を返す、ニューラルネットワークの活性化関数を指す。類似するReLUやSwish関数の代替として使われる。. DeepLearning基礎技術まとめ #Python - Qiita. 1.3 活性化関数 活性化関数とは,先ほど話したように1つ前から次の層に値を渡すときにひと手間加える関数です. 大きな値,特徴として強い部分を強調し,弱い部分は小さくします.必要な特徴を選んで強調することで,学習を活性化させる役割を担っています.. 活性 化 関数 と は物体検出、セグメンテーションをMask R-CNNで理解してみる . 活性化関数にSoftmaxを用いてRPNの領域候補毎×クラス毎の確率を得る。 領域抽出層: ユニット数=クラス数×4で全結合。 RPNの領域候補に対するオフセットを得る。 3.2.Headの学習について 損失関数はRPNと同じ。 クラス識別はlog. 活性 化 関数 と は【図解】なぜ活性化関数が必要なのか #Python - Qiita. 活性 化 関数 と は問題. 活性化関数はディープラーニングの重要な要素の一つです.. ですが何故必要なのでしょうか?. 複雑にしたいなら層を増やせば良いだけなのでは?. なぜ非線形関数である必要があるの?. 活性 化 関数 と はなどの疑問が湧くと思います.. そんな疑問を一緒に …. ニューラルネットの挙動を理解する:全結合層と活性化関数に . 第1層:tanh関数、第2層:ReLU関数、第3層:tanh関数という形で活性化関数を混ぜることでどのような挙動が出るかを可視化しました。 はじめの活性化層で真ん中部分を拡大し、第2層の活性化層で折り畳んだ後、最後の層で再び間を拡大する様が …. 【決定版】スーパーわかりやすい最適化アルゴリズム -損失関数 . 最適化アルゴリズムとは? SGDやらモーメンタムやらAdamやら色々な最適化アルゴリズムを聞きますが、 これらの最適化アルゴリズムは全て最急降下法の派生で、最急降下法さえ理解すれば他の最適化アルゴリズムは理解できてしまう ので …. ソフトマックス(Softmax)関数とは:定義、特性、実装方法ま …. 活性 化 関数 と は他の活性化関数との比較:Softmax関数は、特に多クラス分類問題の出力層に適しており、他の活性化関数と比較して確率分布を出力する特徴がある。 Softmax関数の理解と適用は、機械学習、特にディープラーニングにおける多クラス分類問題において不可欠である。. 活性化関数 | DeepSquare. 活性 化 関数 と は活性化関数とは、人工ニューラルネットワークにおいて、ニューロンが発火するかどうかを決定するための関数。活性化関数は、ニューラルネットワークの中で、入力された信号を出力信号に変換する役割を果たす。 活性化関数は、ニューラルネットワークのモデルの設計段階で決定される。. ReLU とその発展型の活性化関数 [GELU, Swish, Mish など . 1. 波乱 レース を 狙え

70 歳 から の 仕事 女性ReLU (Rectified Linear Units) 型の活性化関数 とは [概要]ReLU (Rectified Linear Units, 整流化線形ユニット)は,ディープニューラルネットワークにおいて広く用いられる,主に中間層向けの活性化関数である [Nair and Hinton, 2010].それまでの3層MLP時代に隠れ層活性化目的で使用されてきた「シグモイド形の . 活性 化 関数 と は【機械学習アルゴリズム】ロジスティック回帰によるモデル . ロジット関数は0よりも大きく、1よりも小さい入力値を受け取り、実数全範囲の値に変換します。 ロジスティックシグモイド関数 ここでは上でした説明を踏まえて、ロジスティック回帰で使う活性化関数について説明していきます。 シグモイド関数. tanh 関数 [活性化関数] | CVMLエキスパートガイド. tanh関数 (Hyperbolic tangent function, 双曲線正接関数) とは,ニューラルネットワークにおいて,隠れ層に用いられる 活性化関数 の1つである.シグモイド関数と関数形が似ている「シグモイド形関数」ではあるが,少し異なった「ゼロ中心・出力 [-1,1]」の関数形 . [活性化関数]ステップ関数(Step function)とは?:AI・機械 . ステップ関数は、ニューラルネットワークの基礎となっている情報処理モデル「パーセプトロン」(後日解説)の活性化関数として用いられていたが、「バックプロパゲーション」(後日解説)が登場してからは「シグモイド関数」が活性化関数として使われるようになり、最近のディープ . 形式ニューロンと活性化関数 :: Jun Nishii - Yamaguchi U. かな で の 杜 フォルテ

四則 演算 と は エクセルパーセプトロン はRosenblattにより1958年に提案された,形式ニューロンを用いた脳の情報処理モデル。. Perceptronの論文は こちら 。. Rosenblattは活性化関数としてステップ関数を用い,分類問題を解く脳モデルとしてパーセプトロンを議論した。. 現在 …. Leaky ReLU関数とは?機械学習の視点で分かりやすく解説!!. 活性 化 関数 と はLeaky ReLU関数 とは、. f(x) = {x (x > 0) αx (x ≤ 0) で表される関数です。. αは微小な値をとり、0.01 が一般的に使われます。. Leaky ReLU関数をグラフで表すとこのような形になります。. ( α = 0.1) Leaky ReLU関数は ディープラーニングの活性化関数の一つ です。. 活性 化 関数 と は【論文解説】Implicit Neural Representations with Periodic . 代わりに、従来の活性化関数と組み合わせて使用すべきだと思います。 最適な結果を得るには、入力位置のエンコードのスケールやと ω 0 omega_0 ω 0 をアプリケーションに応じて合わせるする必要があると思います。. 活性 化 関数 と はGELUの活性化関数の解説 – S-Analysis. 五角形 の 和

1. GELU活性化関数の概要 1.1 GELU活性化関数とは 1.2 GELU定義 1.3 GELUの違い 2. 活性 化 関数 と は実験 2.1 データロード 2.2 データ前処理 2.3 GELU活性化関数のモデル作成 2.4 ReLU活性化関数のモデル作成 2.5 まとめ 活性化関数のまとめ 1